Merge pull request #11 from Everglow0214/master

lecture 14 finished

Showing

docs/14.md

0 → 100644

docs/img/fig14_1.png

0 → 100644

72.5 KB

docs/img/fig14_2.png

0 → 100644

214.4 KB

docs/img/fig14_3.png

0 → 100644

253.7 KB

docs/img/fig14_4.png

0 → 100644

136.5 KB

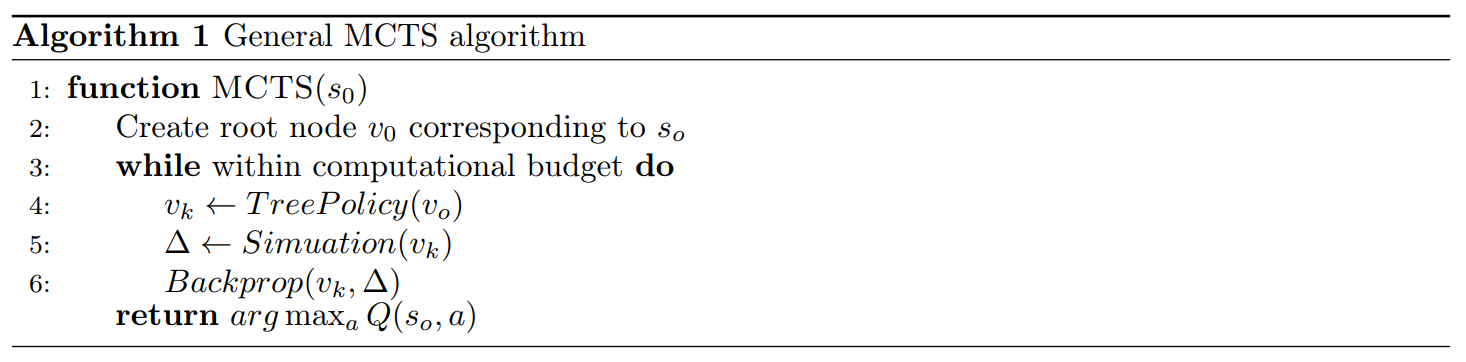

docs/img/fig14_alg_1.png

0 → 100644

79.5 KB

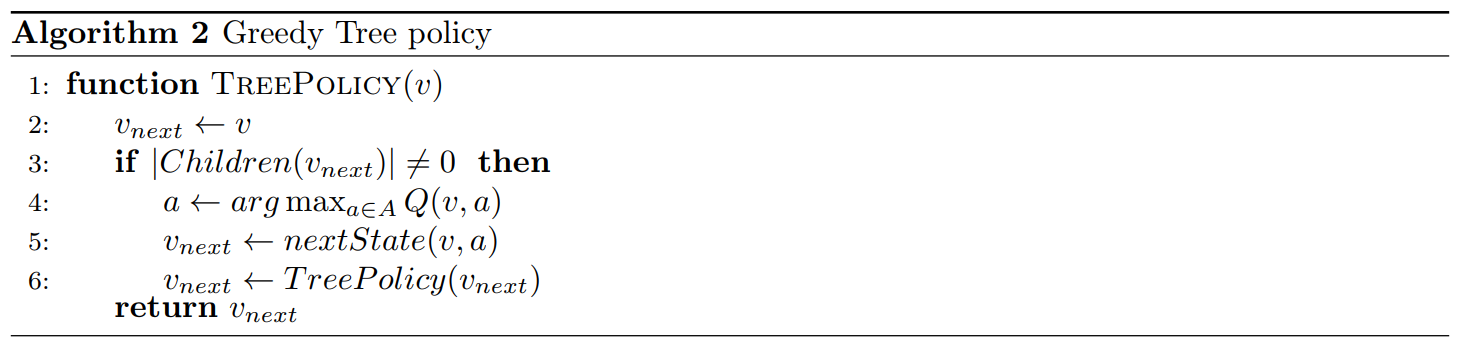

docs/img/fig14_alg_2.png

0 → 100644

64.6 KB

docs/img/fig14_alg_3.png

0 → 100644

64.4 KB