All

Showing

73.6 KB

155.0 KB

120.8 KB

237.7 KB

53.8 KB

172.7 KB

53.4 KB

1004.3 KB

2.8 MB

61.9 KB

218.0 KB

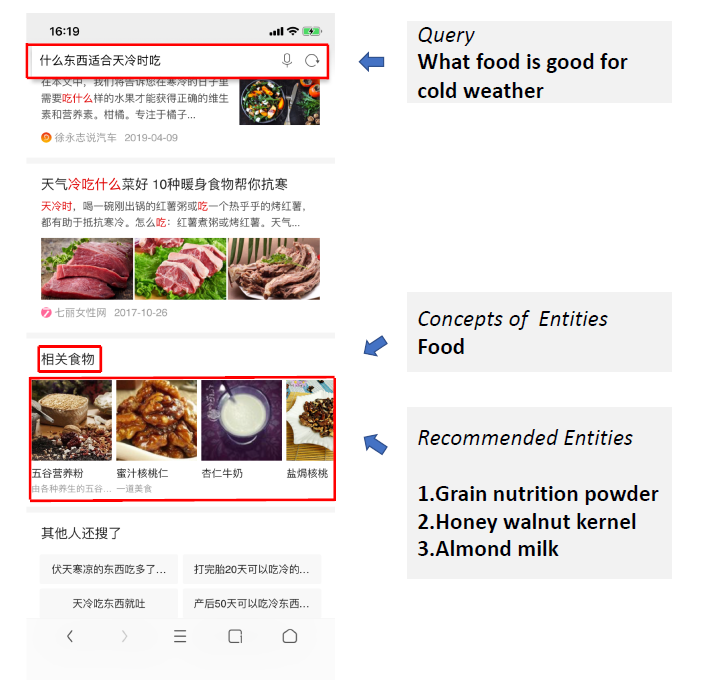

AI/Knowledge Graph/survey.md

0 → 100644

AI/Knowledge Graph/讨论报告.md

0 → 100644

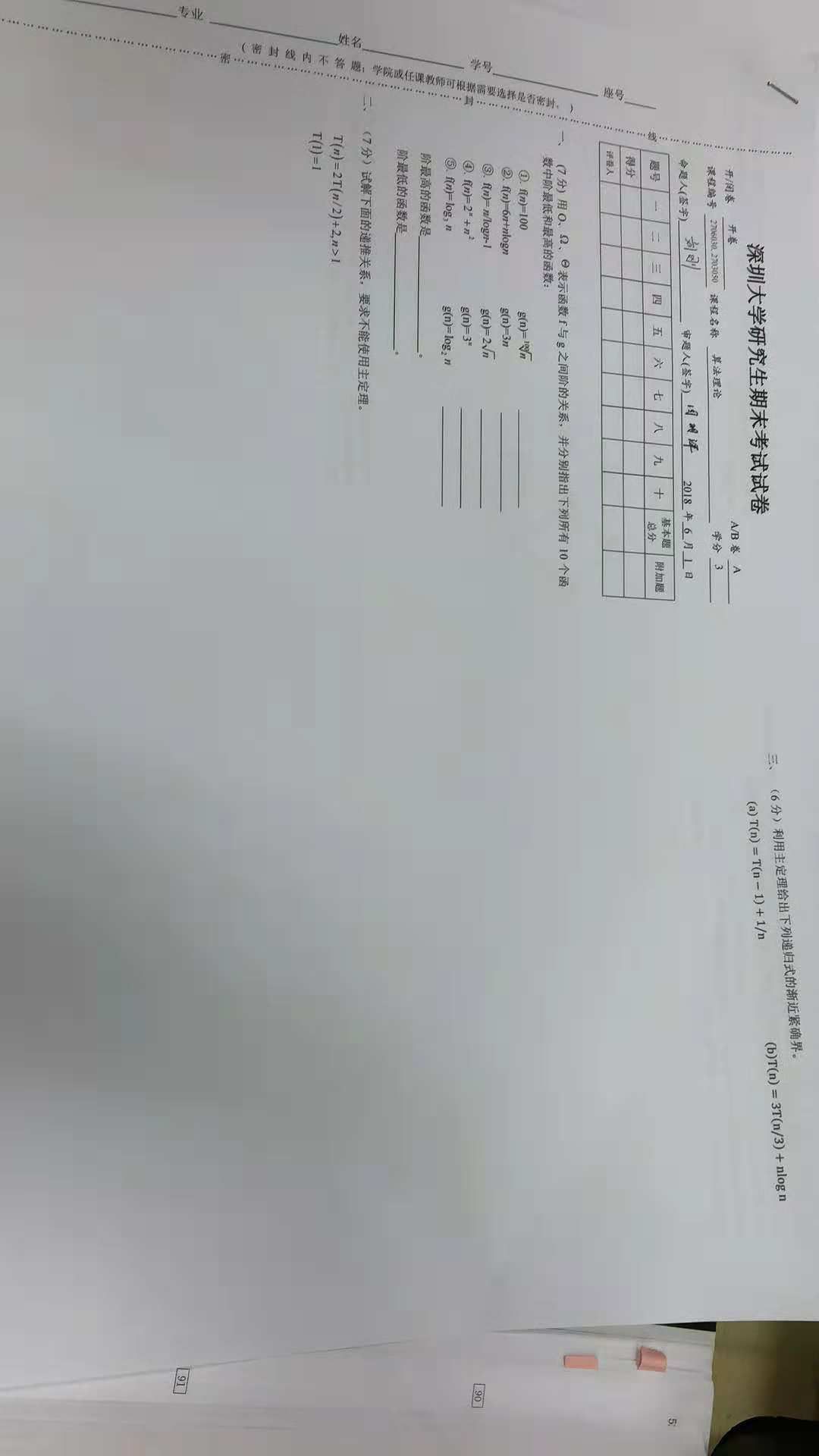

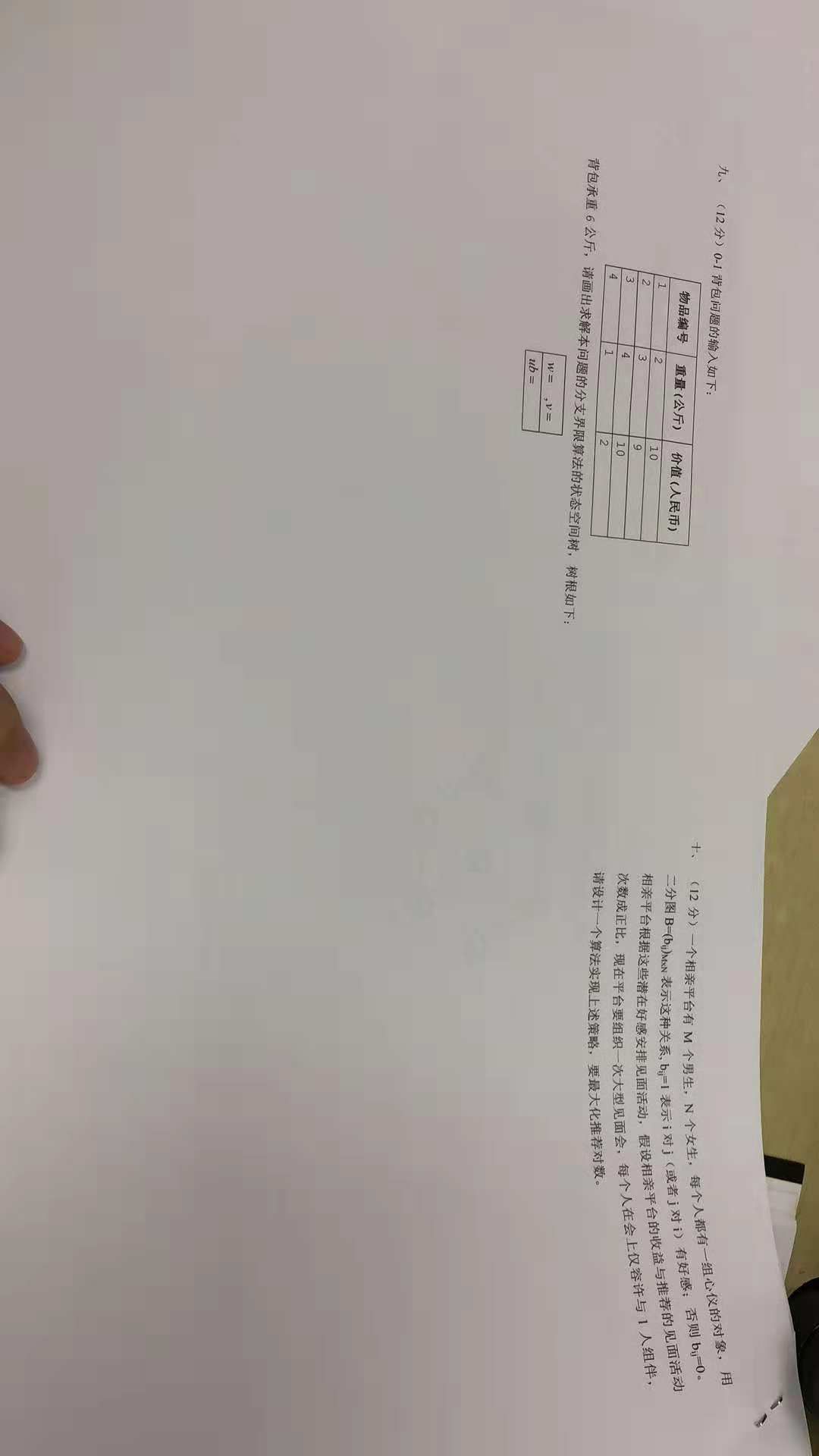

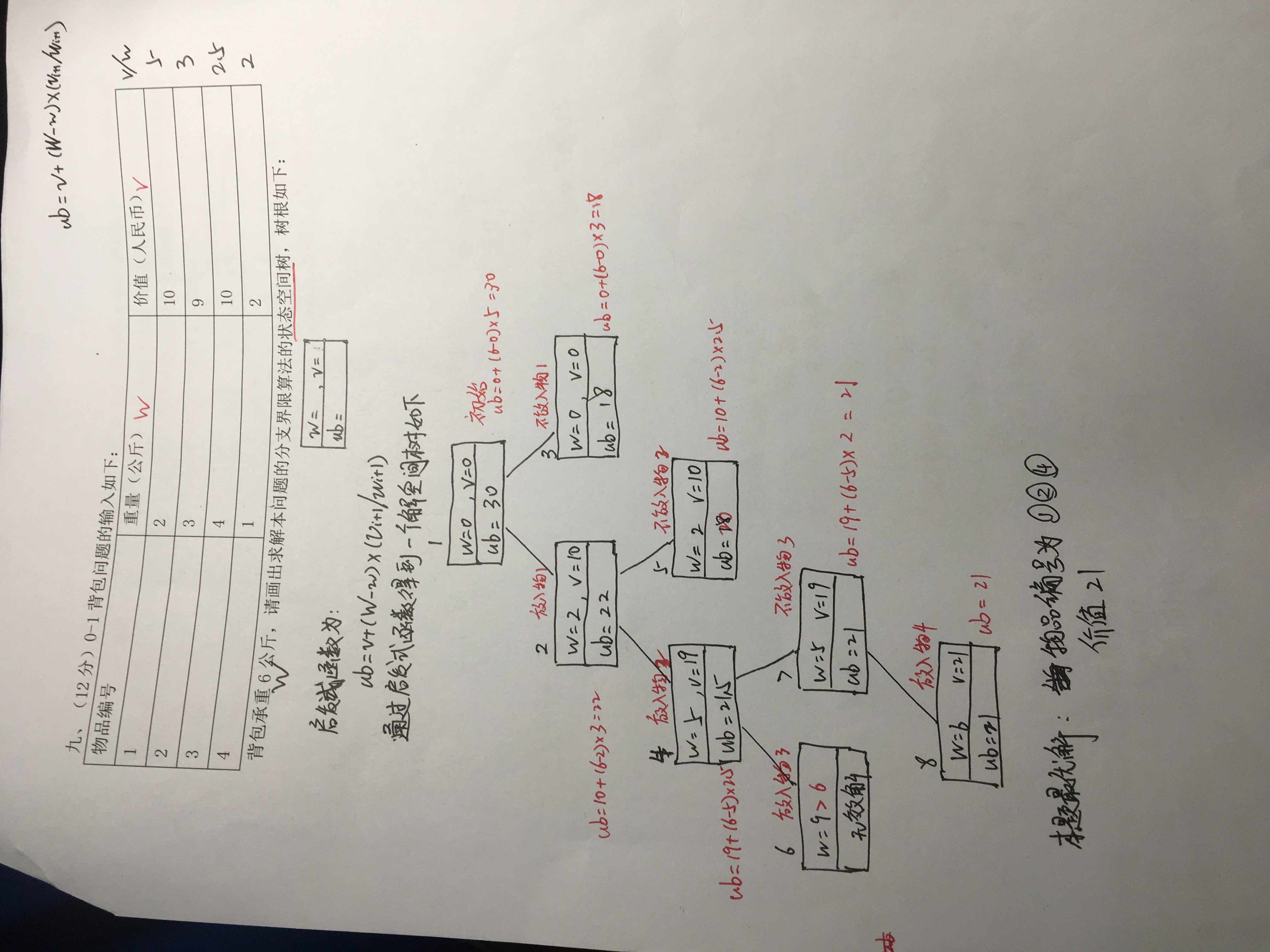

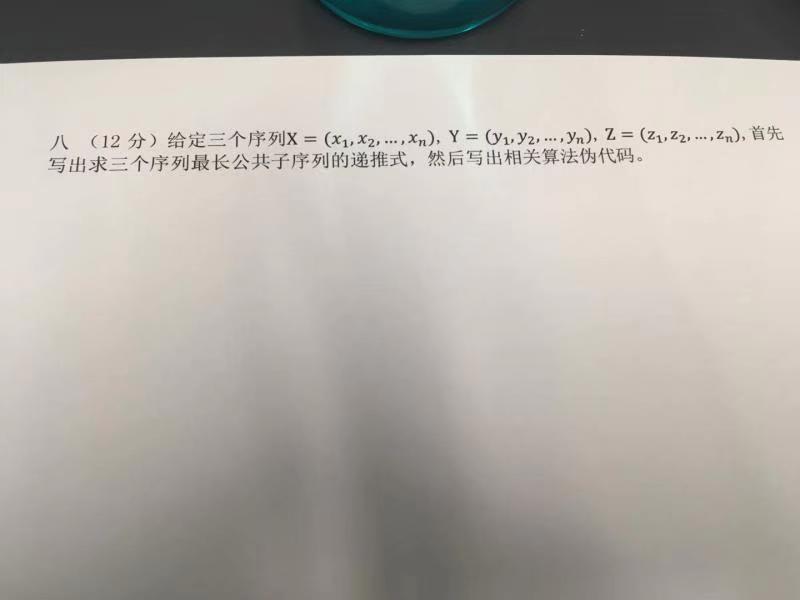

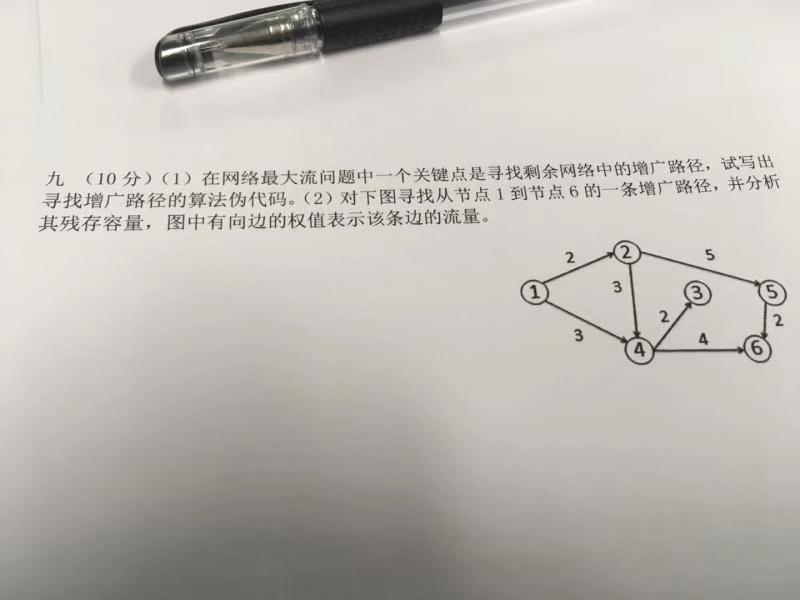

Algorithm/试卷/19_new.txt

0 → 100644

82.8 KB

71.9 KB

70.9 KB

69.3 KB

88.0 KB

1.7 MB

2.1 MB

2.1 MB

1.8 MB

1.5 MB

1.8 MB

1.9 MB

2.1 MB

55.2 KB

61.7 KB

Algorithm/试卷/very_old/1.jpg

0 → 100644

24.9 KB

Algorithm/试卷/very_old/2.jpg

0 → 100644

20.0 KB

Algorithm/试卷/very_old/3.jpg

0 → 100644

39.3 KB

Algorithm/试卷/very_old/4.jpg

0 → 100644

47.7 KB

Algorithm/试卷/very_old/5.jpg

0 → 100644

22.5 KB

Algorithm/试卷/very_old/6.jpg

0 → 100644

30.8 KB

Algorithm/试卷/very_old/7.jpg

0 → 100644

33.4 KB

文件已添加

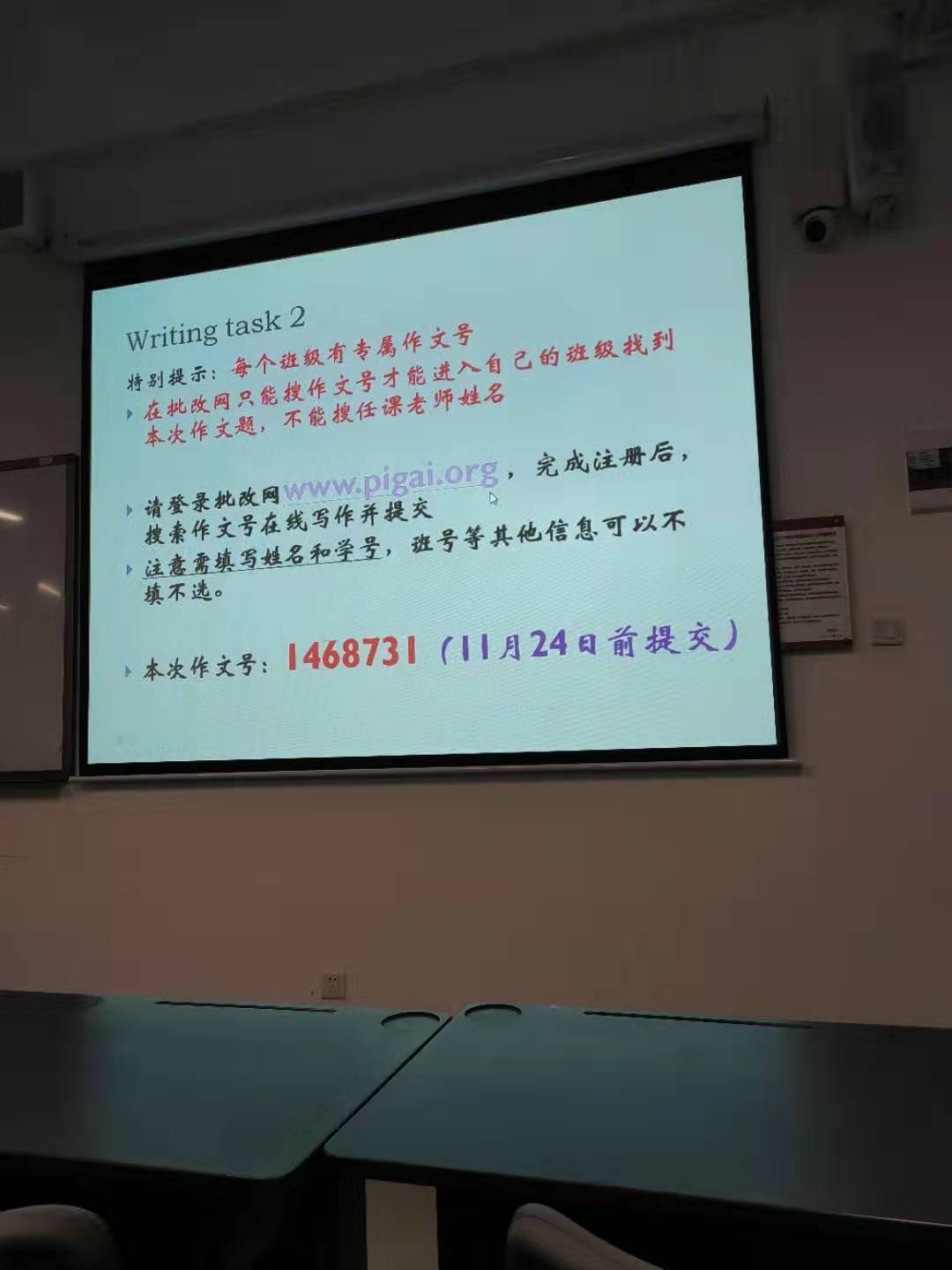

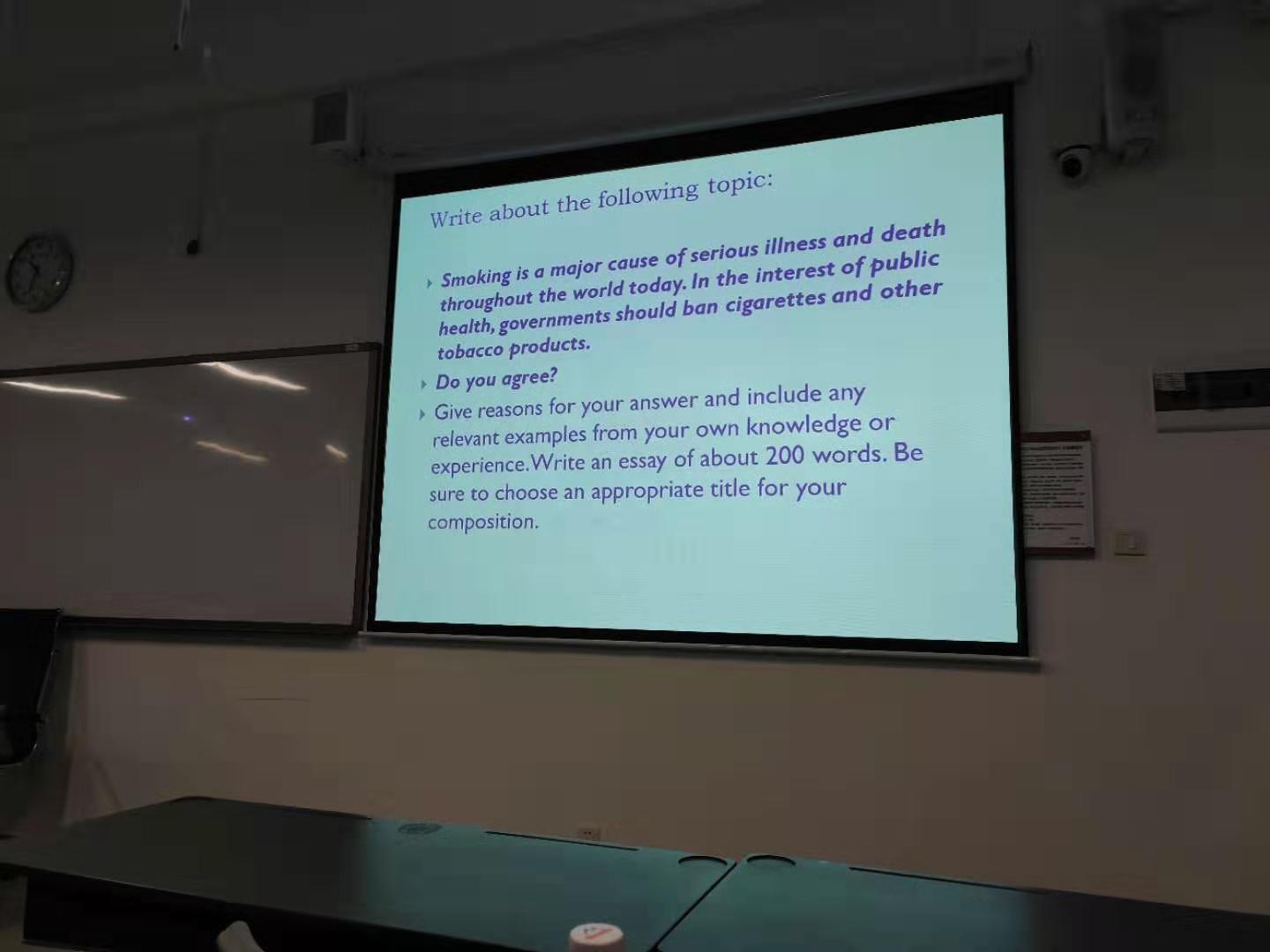

English/Translation final.pptx

0 → 100644

文件已添加

文件已添加

文件已添加

74.1 KB

文件已添加

79.6 KB

79.8 KB

文件已添加

73.1 KB

English/英语考试翻译预测.docx

0 → 100644

文件已添加

FormatTemplate/深圳大学学报理工版模板.docx

0 → 100644

文件已添加

文件已添加

文件已添加

文件已添加

文件已添加

文件已添加

此差异已折叠。

此差异已折叠。

37.2 KB

8.2 KB

1.6 MB

12.0 KB

文件已添加

文件已添加

文件已添加

文件已添加

文件已添加

66.6 KB

28.0 KB

55.3 KB

42.0 KB

28.8 KB

文件已添加

ThesisWritingGuide/example.png

0 → 100644

2.7 MB

ThesisWritingGuide/note.md

0 → 100644

ThesisWritingGuide/要点.png

0 → 100644

2.3 MB