4-19

Showing

images/chapter_7/7-10.png

0 → 100644

63.5 KB

images/chapter_7/7-11.png

0 → 100644

58.9 KB

images/chapter_7/7-12.png

0 → 100644

43.5 KB

images/chapter_7/7-13.png

0 → 100644

35.8 KB

images/chapter_7/7-14.png

0 → 100644

48.9 KB

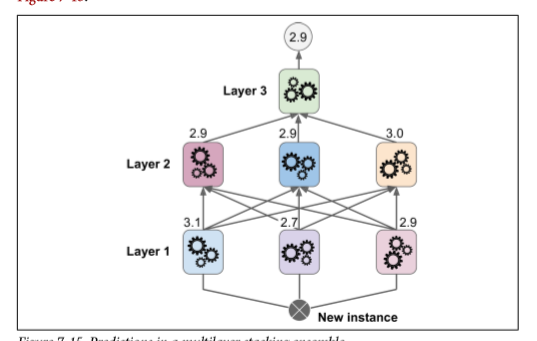

images/chapter_7/7-15.png

0 → 100644

45.6 KB

images/chapter_7/7-9.png

0 → 100644

146.3 KB

images/chapter_7/E7-2.png

0 → 100644

2.5 KB

images/chapter_7/E7-3.png

0 → 100644

7.7 KB

images/chapter_7/E7-4.png

0 → 100644

5.4 KB