ch14 pic

Showing

images/chapter_14/14-1.png

0 → 100644

74.4 KB

images/chapter_14/14-2.png

0 → 100644

114.6 KB

images/chapter_14/14-3.png

0 → 100644

53.9 KB

images/chapter_14/14-4.png

0 → 100644

169.3 KB

images/chapter_14/14-5.png

0 → 100644

78.3 KB

images/chapter_14/14-6.png

0 → 100644

45.8 KB

images/chapter_14/14-7.png

0 → 100644

102.1 KB

images/chapter_14/14-8.png

0 → 100644

86.8 KB

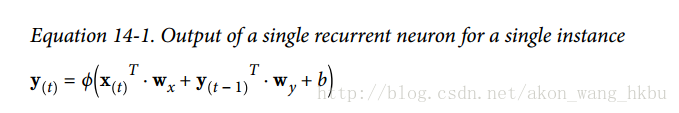

images/chapter_14/e-14-1.png

0 → 100644

20.8 KB

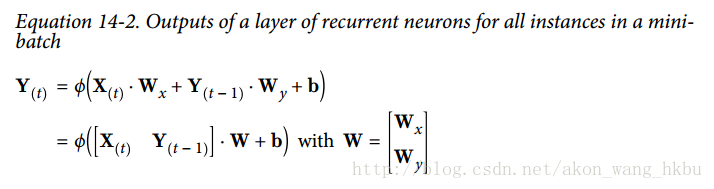

images/chapter_14/e-14-2.png

0 → 100644

32.3 KB

images/chapter_14/o-14-1.png

0 → 100644

71.5 KB

images/chapter_14/o-14-2.png

0 → 100644

77.9 KB

images/chapter_14/o-14-3.png

0 → 100644

44.1 KB

images/chapter_14/o-14-4.png

0 → 100644

11.5 KB

images/chapter_14/o-14-5.png

0 → 100644

31.6 KB

images/chapter_14/o-14-6.png

0 → 100644

59.0 KB