[add] 添加 prometheus operator文章

Showing

deploymentdemo/deploy-svc.yaml

0 → 100644

docs/57.AlertManager的使用.md

0 → 100644

此差异已折叠。

docs/58.Prometheus Operator.md

0 → 100644

此差异已折叠。

118.1 KB

100.1 KB

95.7 KB

132.9 KB

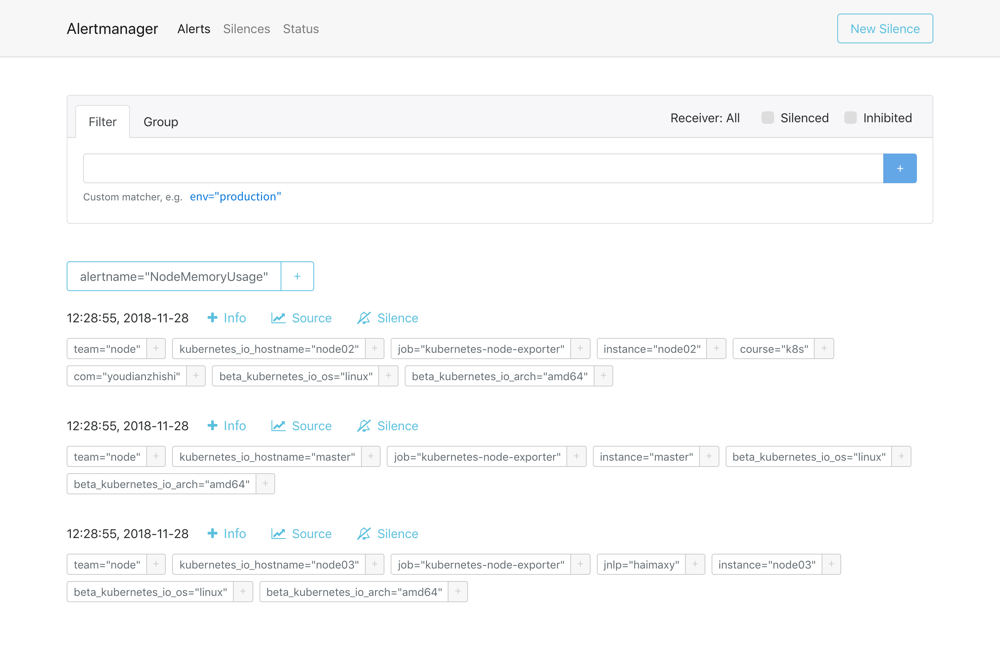

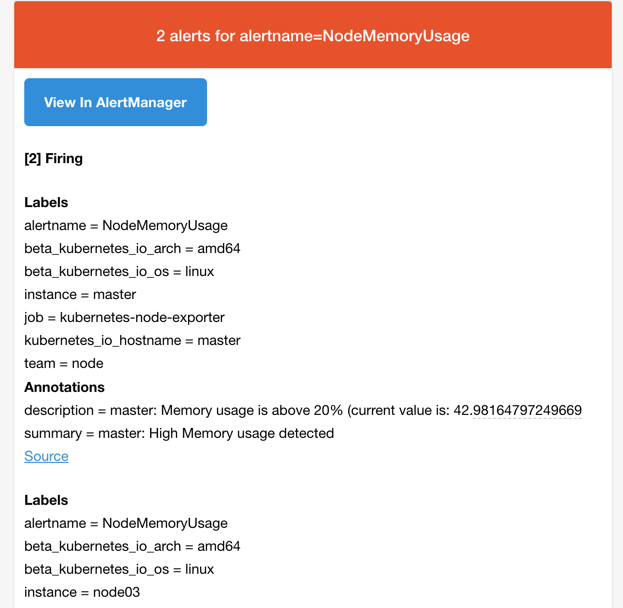

docs/images/prometheus-alerts.png

0 → 100644

168.4 KB

162.9 KB

147.6 KB

87.6 KB

532.5 KB

64.1 KB

49.7 KB

719.9 KB

prome/dingtalk-hook.yaml

0 → 100644