docs(img): change img path

Showing

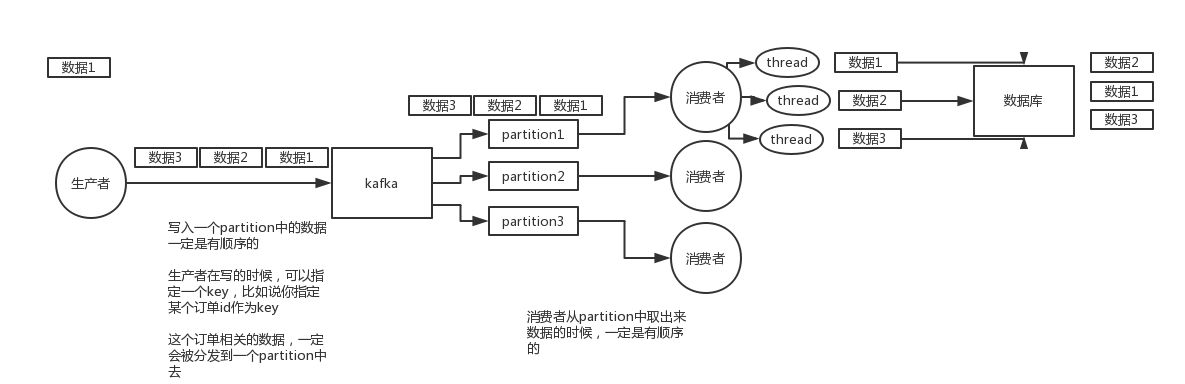

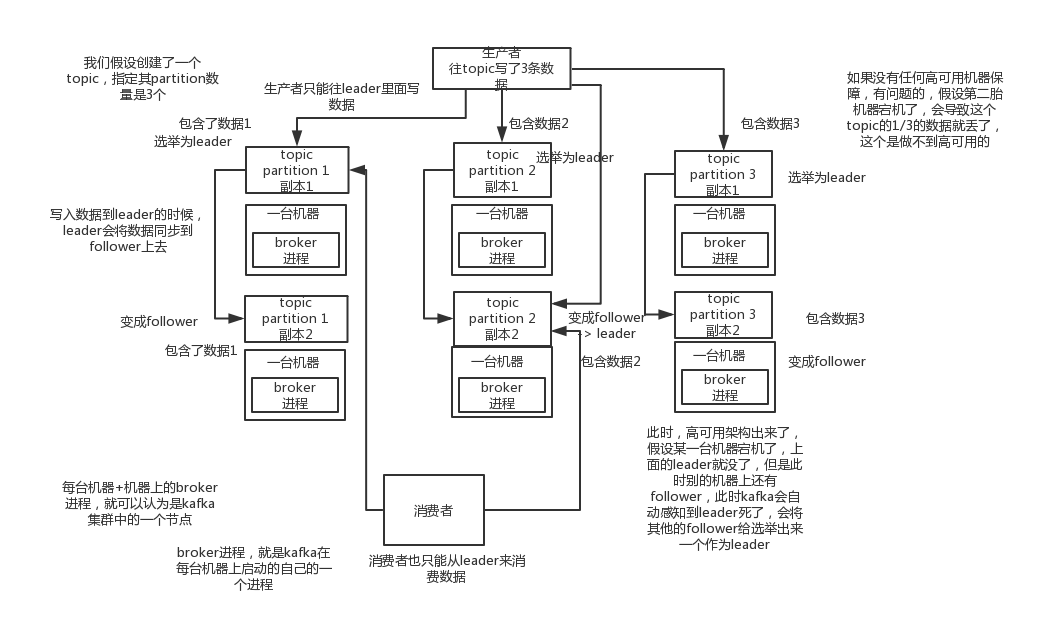

img/kafka-order-1.png

0 → 100644

64.4 KB

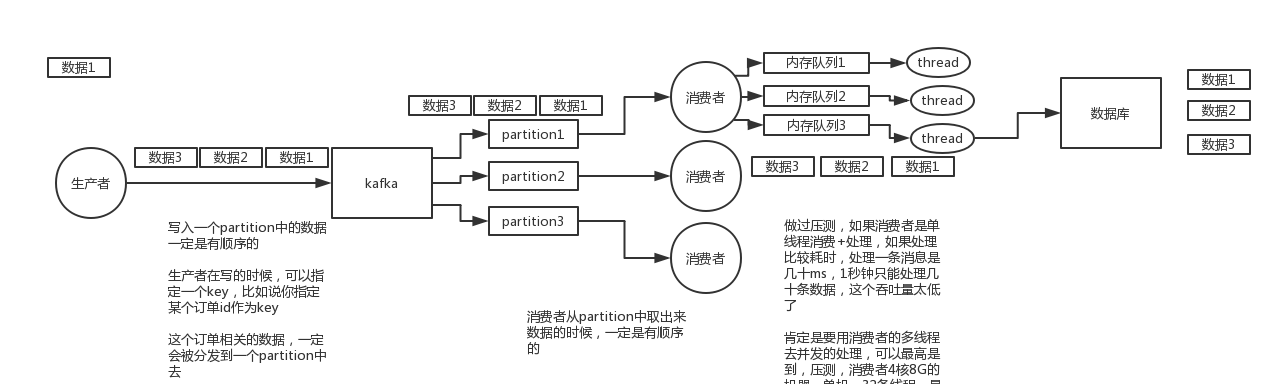

img/kafka-order-2.png

0 → 100644

98.3 KB

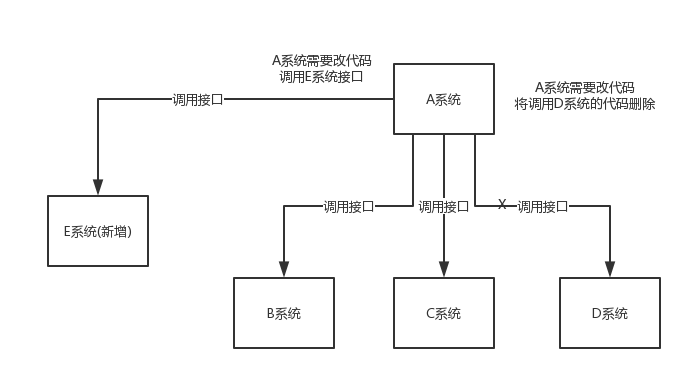

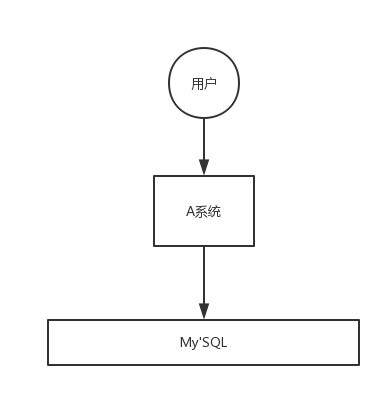

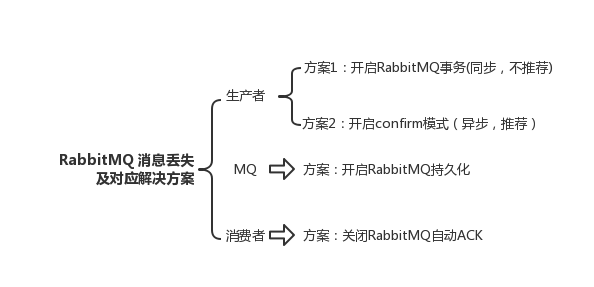

img/mq-1.png

0 → 100644

22.5 KB

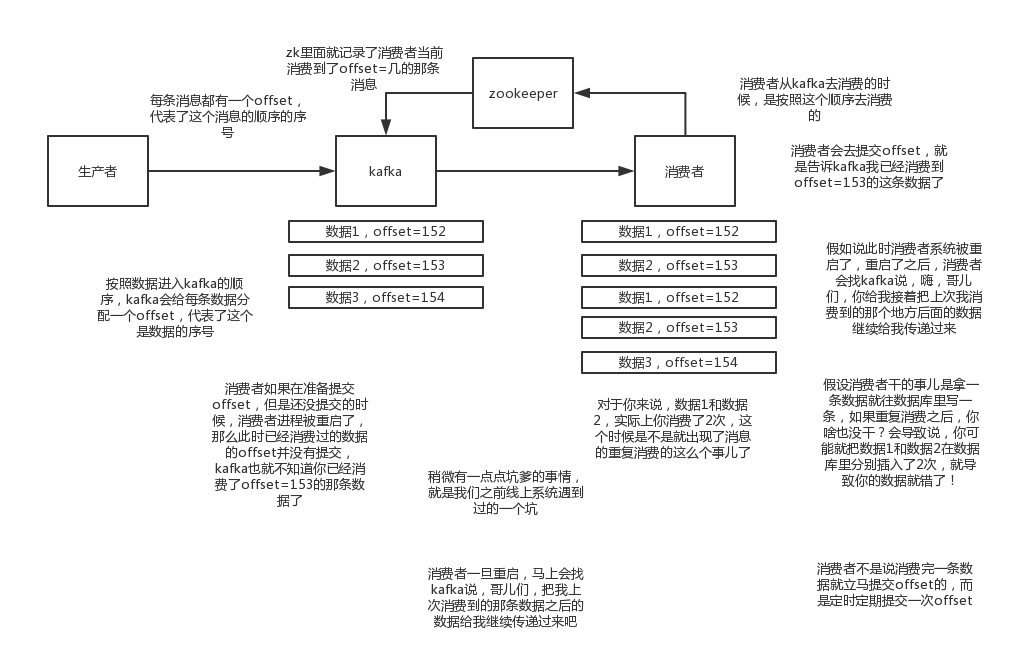

img/mq-10.png

0 → 100644

162.4 KB

img/mq-11.png

0 → 100644

16.8 KB

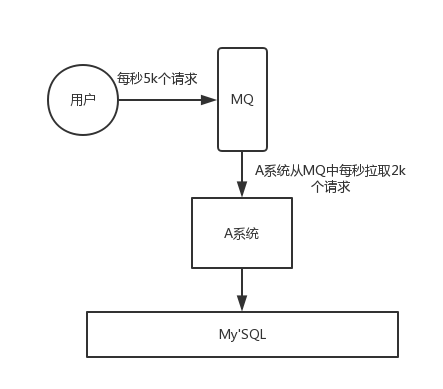

img/mq-2.png

0 → 100644

28.2 KB

img/mq-3.png

0 → 100644

15.9 KB

img/mq-4.png

0 → 100644

26.0 KB

img/mq-5.png

0 → 100644

7.9 KB

img/mq-6.png

0 → 100644

16.6 KB

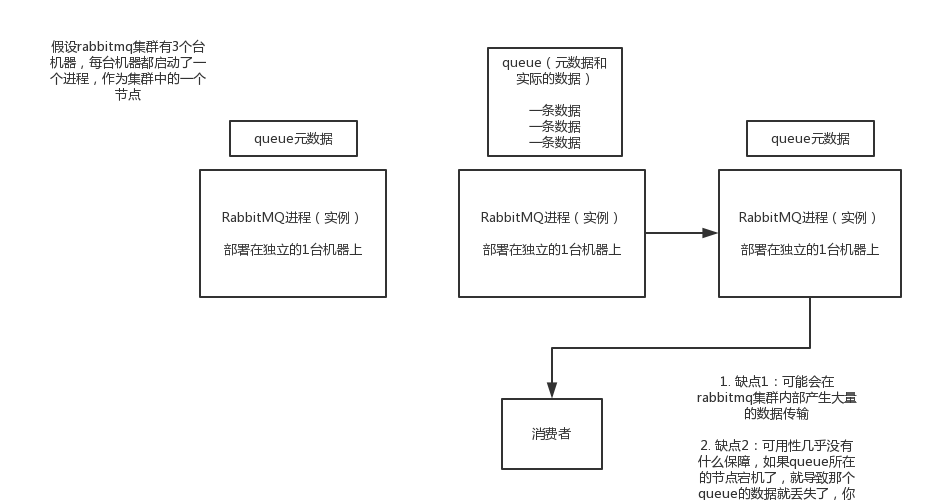

img/mq-7.png

0 → 100644

50.5 KB

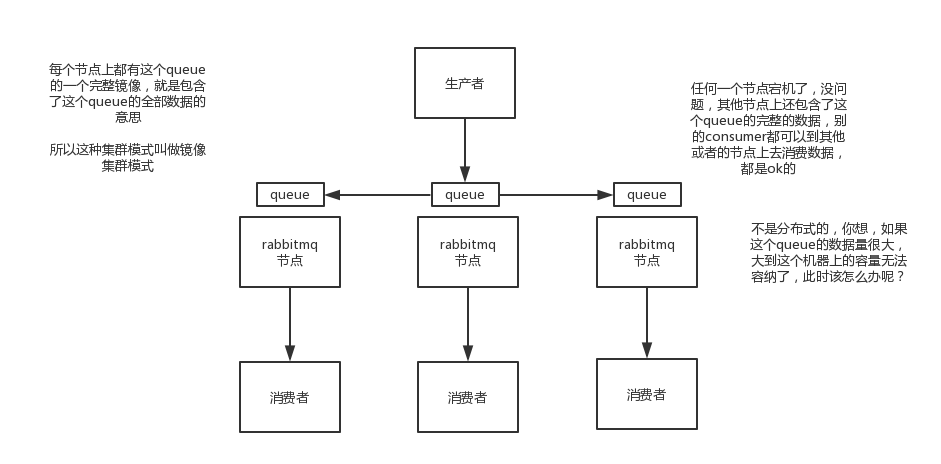

img/mq-8.png

0 → 100644

54.0 KB

img/mq-9.png

0 → 100644

113.8 KB

28.0 KB

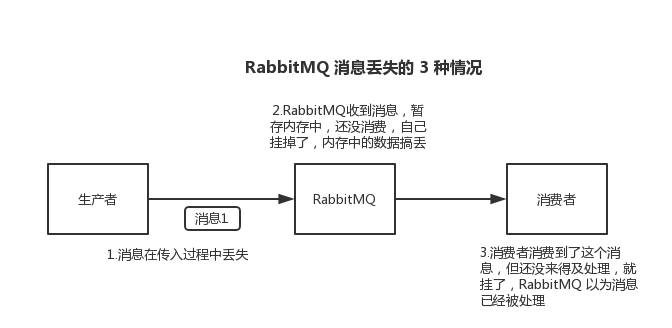

img/rabbitmq-message-lose.png

0 → 100644

33.5 KB

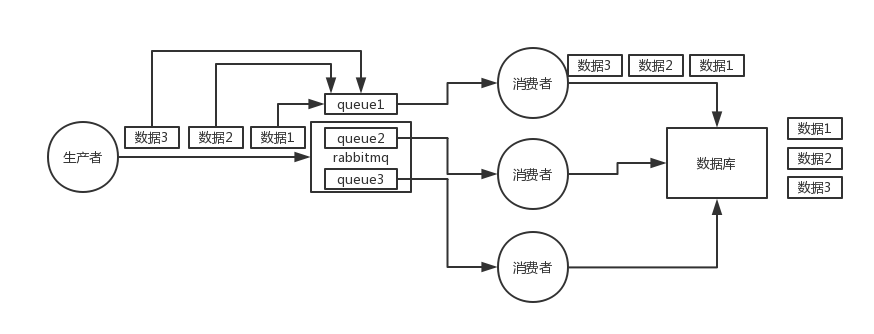

img/rabbitmq-order-1.png

0 → 100644

28.9 KB

img/rabbitmq-order-2.png

0 → 100644

29.0 KB