docs(mq): update

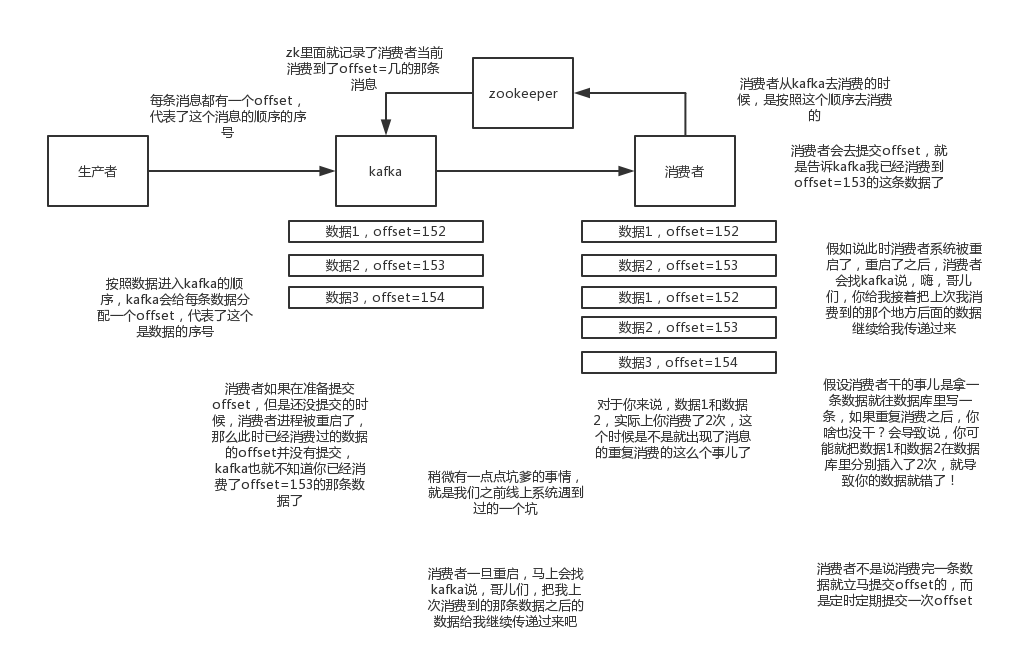

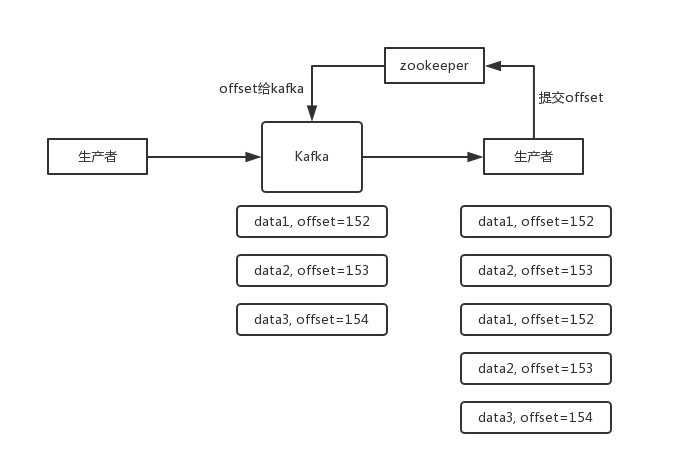

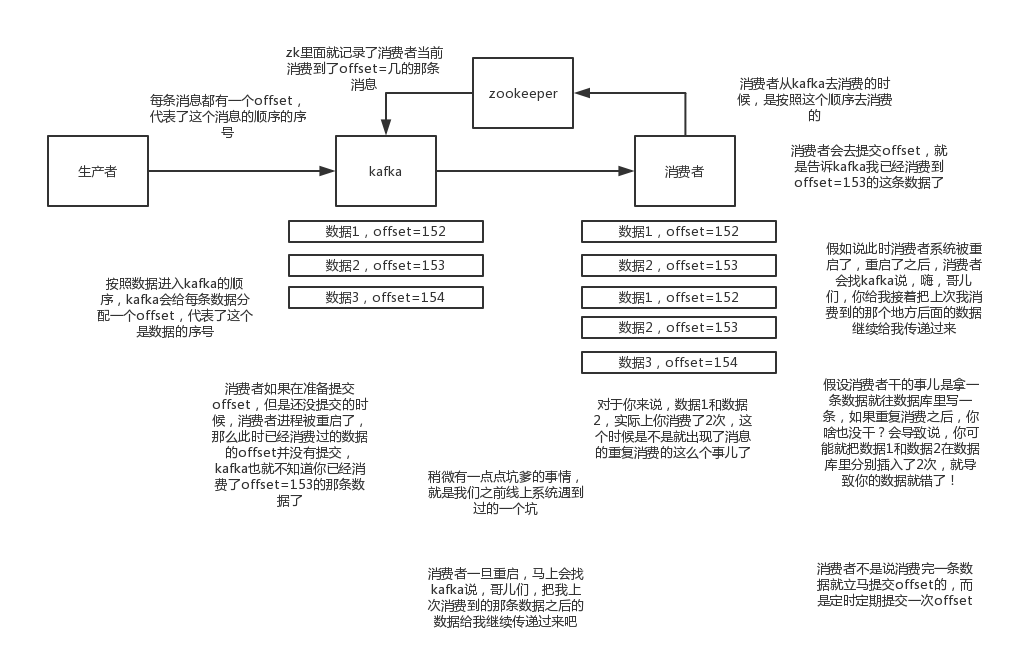

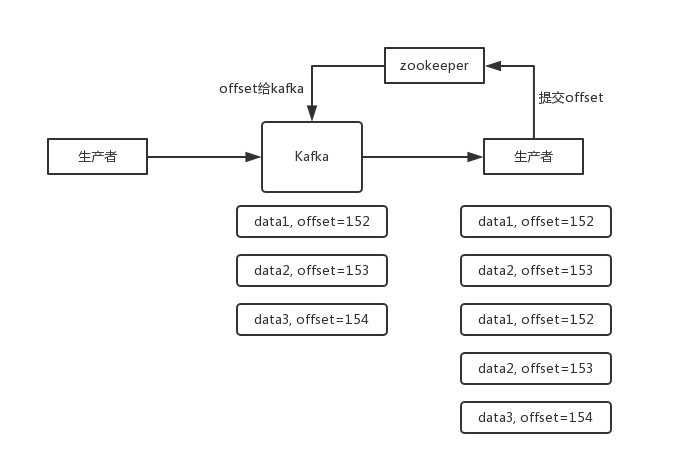

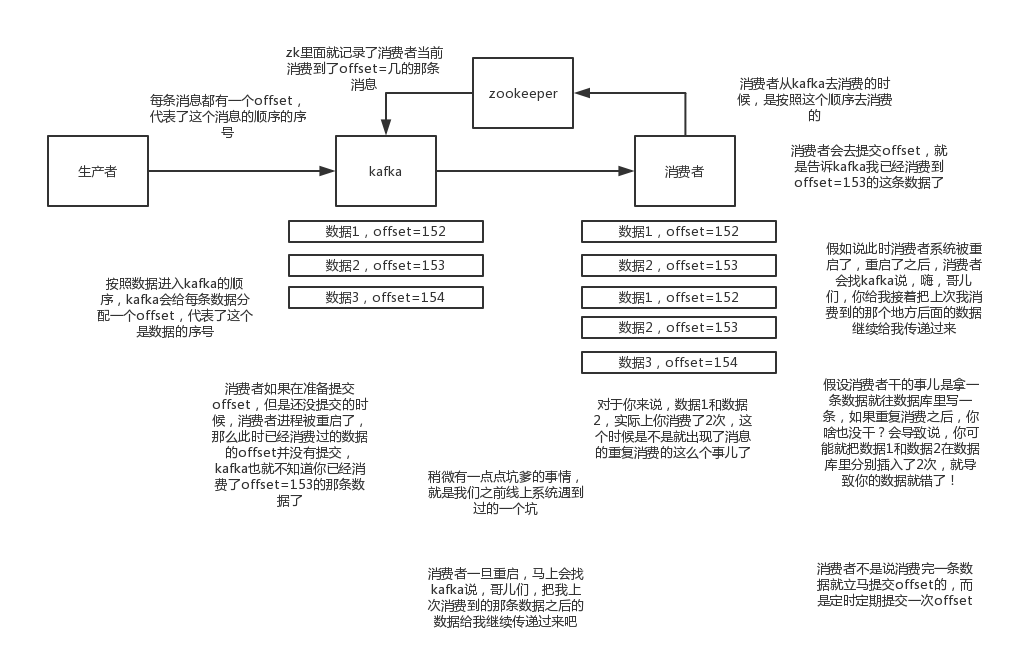

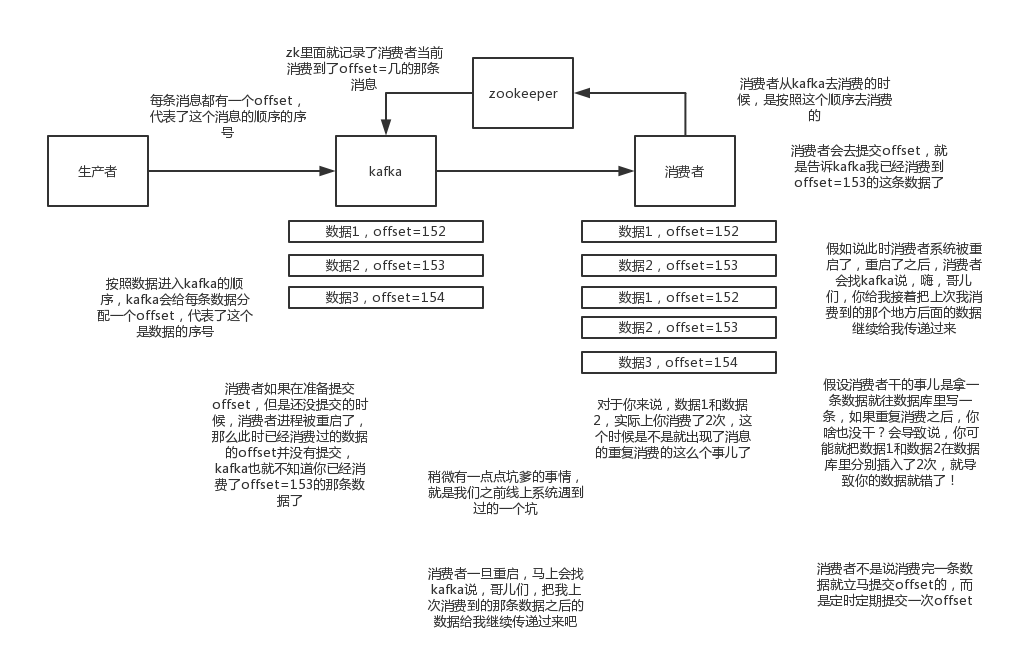

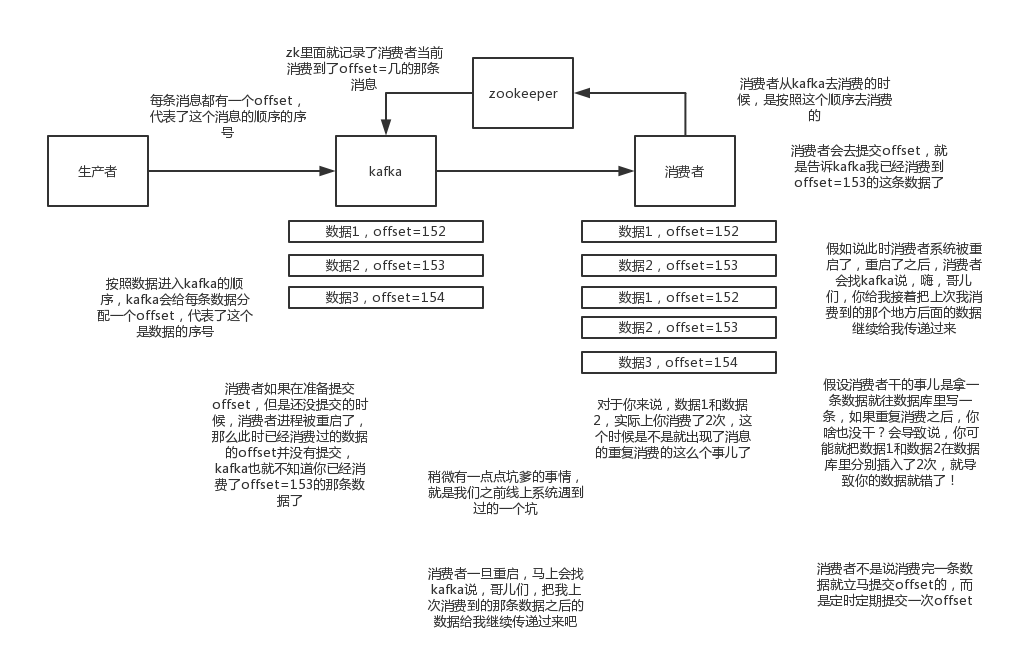

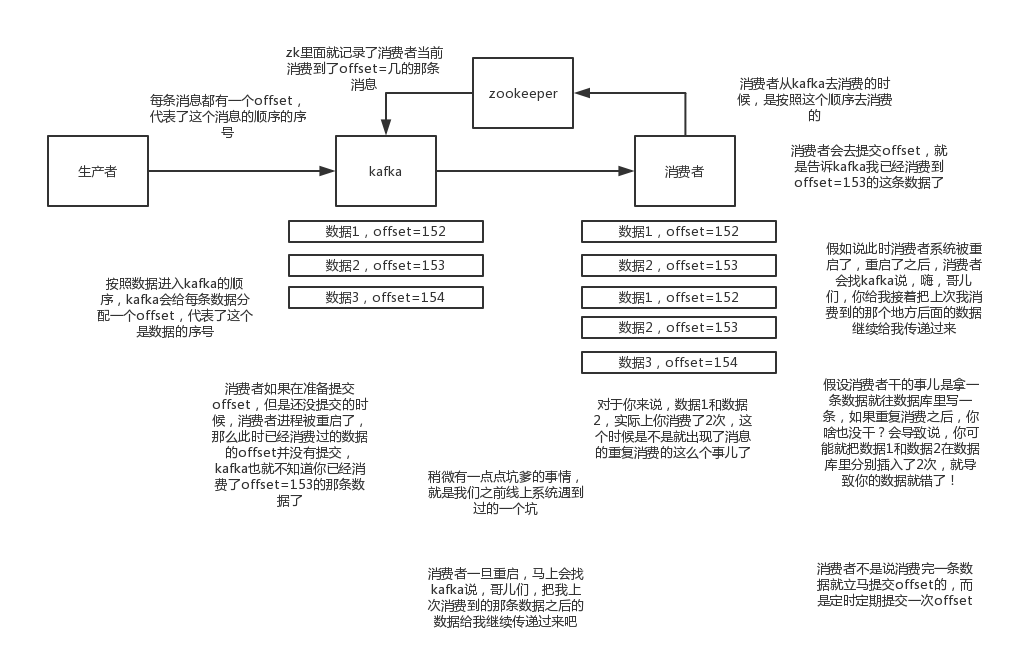

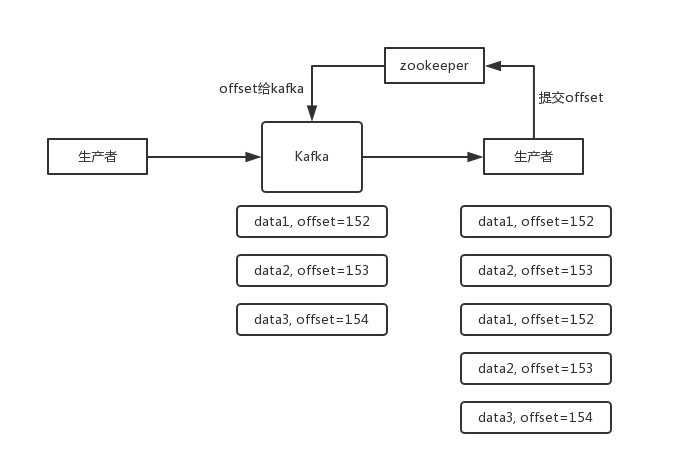

how-to-ensure-that-messages-are-not-repeatedly-consumed.md 修改保证消息不被重复消费的语言描述,更直观!

Showing

| W: | H:

| W: | H:

从无法访问的项目Fork

how-to-ensure-that-messages-are-not-repeatedly-consumed.md 修改保证消息不被重复消费的语言描述,更直观!

162.4 KB | W: | H:

19.1 KB | W: | H: