大数据学习。

Showing

BigData/awesome.md

0 → 100644

BigData/go-hadoop.md

0 → 100644

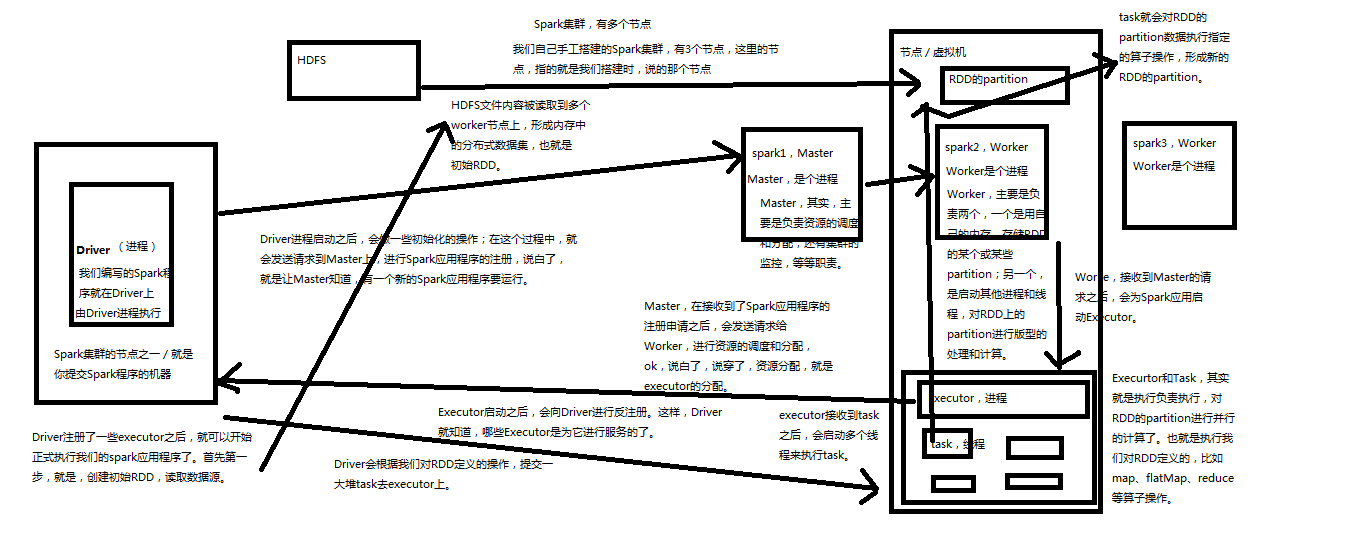

BigData/img/spark-flow.png

0 → 100644

65.0 KB

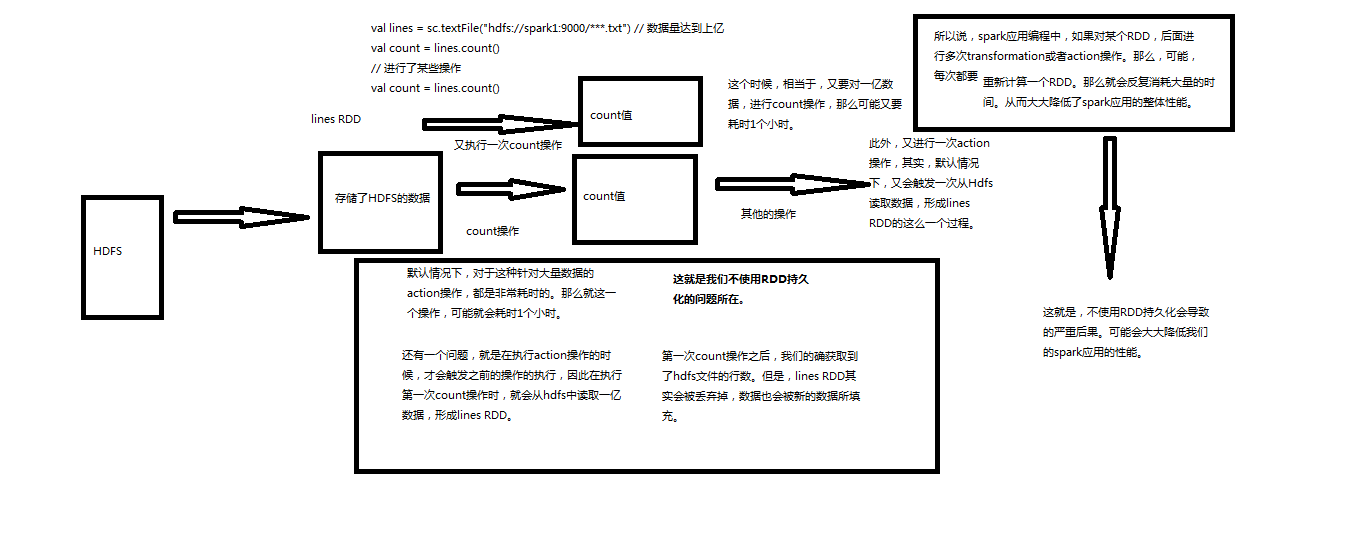

42.0 KB

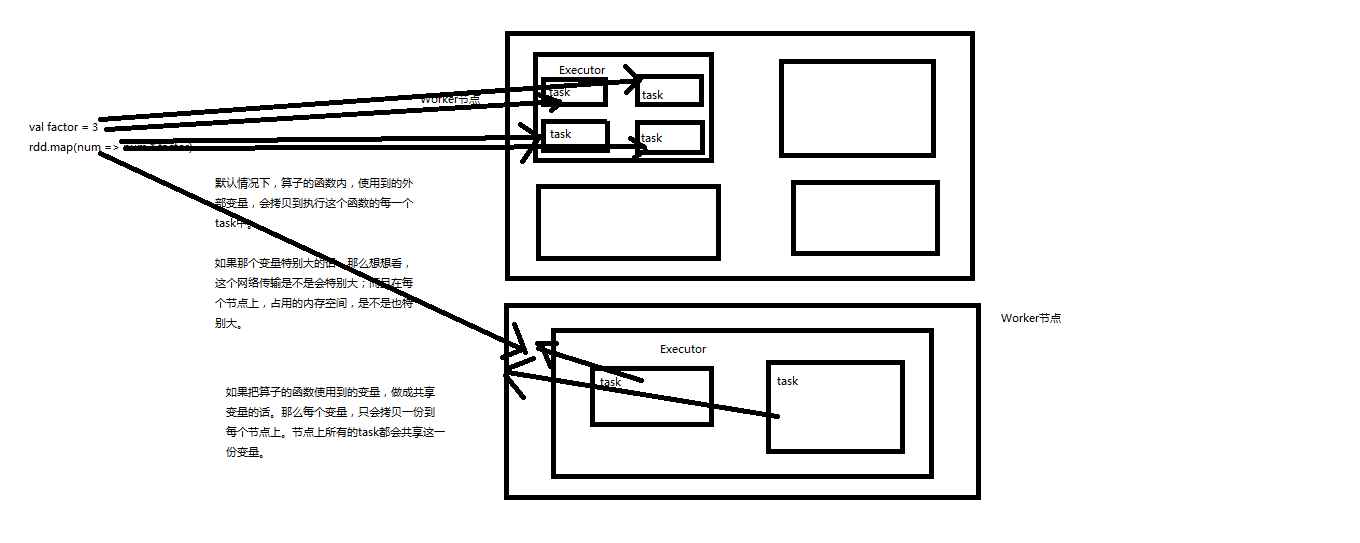

BigData/img/spark-share-vars.png

0 → 100644

28.2 KB

BigData/spark-rdd.md

0 → 100644

articles/blog-design.md

0 → 100644

此差异已折叠。

golang/Go 编译器内核-给 Go 新增一个语句.md

0 → 100644

tools/gcc-make-llvm-etc.md

0 → 100644

win/chrome.md

0 → 100644