doc: add curve metric analyze

Signed-off-by: Nilixiaocui <ilixiaocui@163.com>

Showing

docs/cn/Curve块存储性能调优指南.md

0 → 100644

1.1 MB

388.9 KB

docs/images/0102-diskcache1.jpg

0 → 100644

418.1 KB

docs/images/0102-diskcache2.jpg

0 → 100644

423.9 KB

1.4 MB

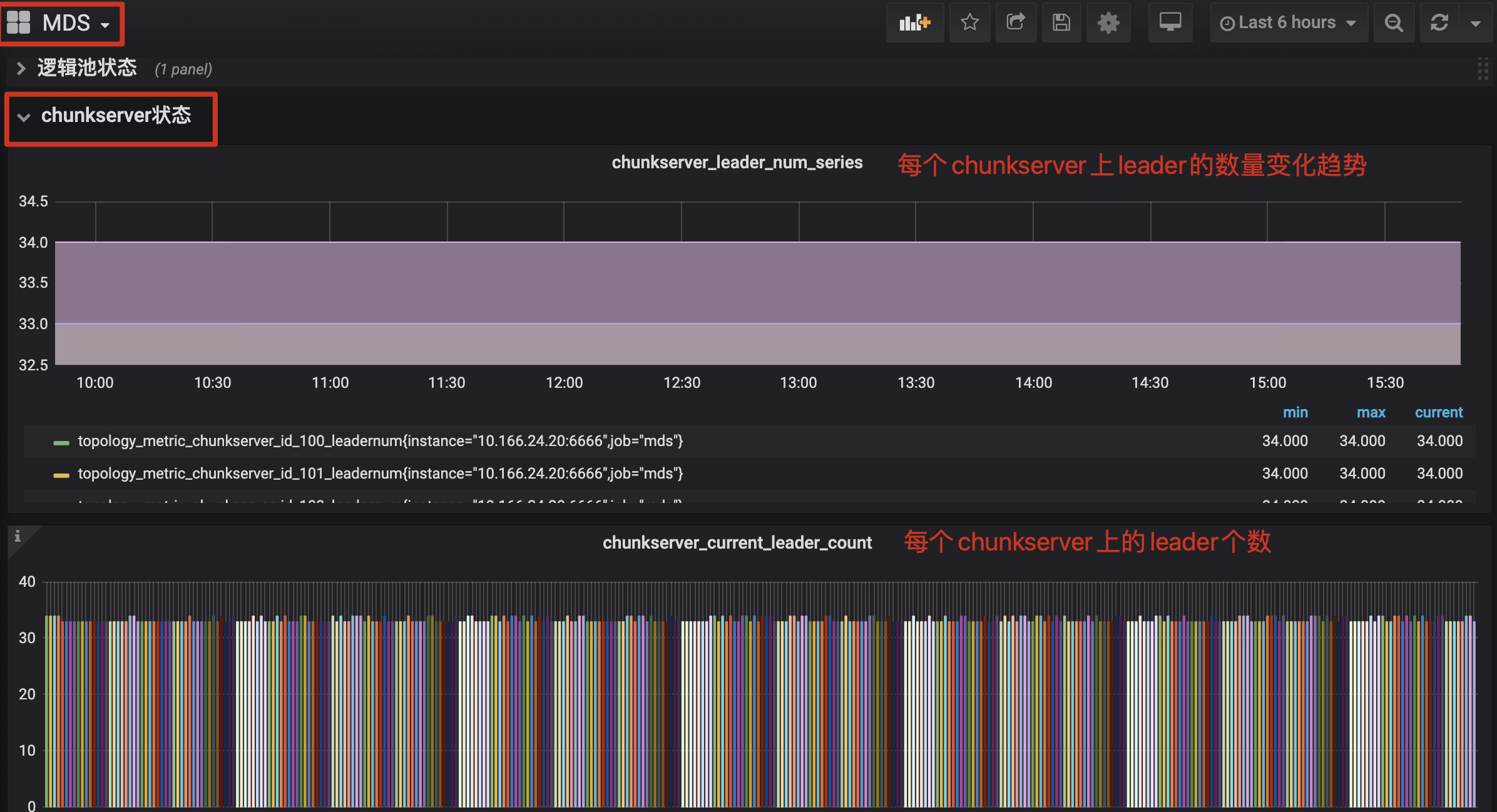

docs/images/0102-leadermetric.jpg

0 → 100644

1.2 MB